L’IA générative dans les DSE : une aide précieuse pour les médecins, mais avec des limites à ne pas négliger

L'IA générative se présente comme un outil prometteur pour alléger la charge de travail des médecins et améliorer l'éducation des patients.

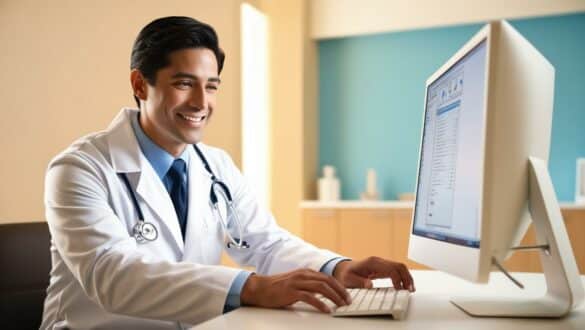

L’IA à la rescousse des médecins submergés

L’épuisement professionnel des médecins atteint des niveaux alarmants, en partie à cause de la charge administrative croissante liée à la documentation et aux tâches diverses. Pour remédier à ce problème, les fournisseurs de dossiers de santé électroniques (DSE) intègrent de plus en plus d’outils d’IA générative qui assistent les médecins dans la rédaction de leurs réponses aux messages des patients. Mais quelle est l’efficacité réelle de ces outils ? Sont-ils sûrs et fiables ?

Des chercheurs du Mass General Brigham se sont penchés sur ces questions en menant une étude sur les performances des outils d’IA générative dans le contexte des DSE. Leurs résultats, publiés dans The Lancet Digital Health, révèlent que ces outils peuvent effectivement alléger la charge de travail des médecins et améliorer l’éducation des patients.

GPT-4 mis à l’épreuve : un dialogue entre l’IA et les oncologues

Pour mener leur étude, les chercheurs ont utilisé GPT-4, un grand modèle de langage développé par OpenAI, pour générer des réponses à 100 questions hypothétiques posées par des patients atteints de cancer. Ces réponses ont ensuite été comparées aux réponses rédigées manuellement par six radio-oncologues.

L’analyse a révélé que les médecins avaient tendance à rédiger des réponses plus courtes que GPT-4, qui incluait généralement plus d’informations éducatives pour les patients. Cependant, les réponses du modèle de langage étaient également jugées moins directes et pédagogiques par les oncologues.

Un atout précieux pour les médecins, mais sous surveillance

Dans l’ensemble, les médecins ont accueilli favorablement l’utilisation de GPT-4 pour les aider à rédiger leurs réponses aux messages des patients, soulignant son potentiel pour réduire leur charge de travail et l’épuisement professionnel associé. Ils ont estimé que les réponses générées par l’IA étaient sûres dans 82 % des cas et acceptables pour être envoyées sans modification dans 58 % des cas.

Malgré ces résultats encourageants, l’étude met en lumière la nécessité d’une supervision humaine constante. En effet, 7 % des réponses produites par GPT-4 présentaient un risque potentiel pour la sécurité des patients si elles n’étaient pas modifiées. Ce risque est souvent lié à une mauvaise appréciation de l’urgence de la situation par le modèle de langage.

Le Dr Danielle Bitterman, auteure de l’étude et radio-oncologue au Mass General Brigham, souligne ce point : “Ces modèles sont formés pour être polis et rassurants, ce qui peut parfois les amener à minimiser l’urgence d’une situation.”

Des recherches futures pour une meilleure compréhension de l’impact sur les patients

L’étude du Mass General Brigham apporte des éléments précieux sur le potentiel et les limites de l’IA générative dans les DSE. Des recherches complémentaires seront nécessaires pour mieux comprendre l’impact de cette technologie sur l’expérience des patients et identifier les moyens d’optimiser son utilisation pour garantir une prise en charge médicale sûre et de qualité.

L’IA générative se présente comme un outil prometteur pour alléger la charge de travail des médecins et améliorer l’éducation des patients. Cependant, son utilisation doit s’accompagner d’une supervision humaine attentive pour garantir la sécurité et l’exactitude des informations transmises aux patients.